又是發布AI憲法又是抵制中國,這位AI大佬走火入魔了

牆內自媒體K和他的AI同事文章:對內培養AI的好價值觀,對外阻止壞人獲取AI能力。

如果要用壹句話概括Anthropic的CEO Dario Amodei過去壹年在做的事情,大概就是這句。

他給自家模型Claude寫了壹份23000字的AI憲法,詳細規定了這個AI應該擁有什麼樣的價值觀、怎麼處理道德困境、甚至討論了它是否可能擁有意識。與此同時,他是硅谷最積極呼吁封鎖中國AI芯片供應的科技公司CEO,沒有之壹。這兩件事之間的關系,比大多數人以為的要緊密得多。

01

先說說AI憲法的事。

Anthropic從2022年開始就在用壹種叫Constitutional AI的方法來訓練Claude。早期版本的“憲法”很多內容直接是從聯合國人權宣言和蘋果的用戶協議裡摘出來的,都是“請選擇更支持生命、自由和人身安全的回答”之類的內容。但現在,Anthropic覺得這種“刻在石板上的戒律”對於現在的模型能力來說已經不夠用了,所以新版憲法中大量篇幅都在試圖解釋為什麼要這麼做。

Amanda Askell是這份文件的主要作者,她是壹個受過哲學訓練的人,在Anthropic專門負責塑造Claude的人格。

她用了壹個很有意思的比喻:想象你突然發現你六歲的孩子是個天才,你就不能糊弄他了,因為他能看穿你。

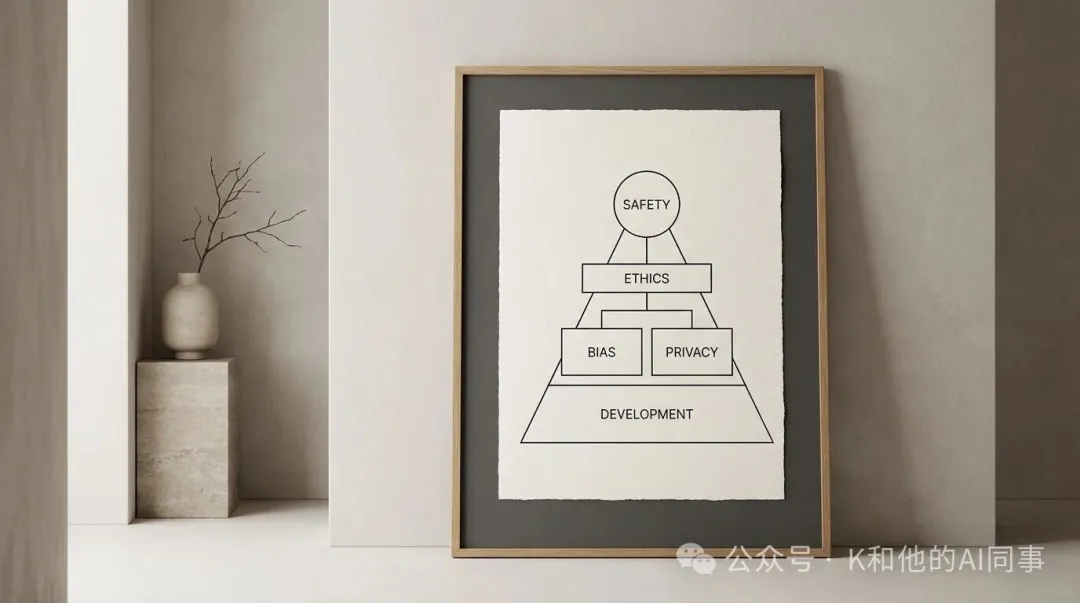

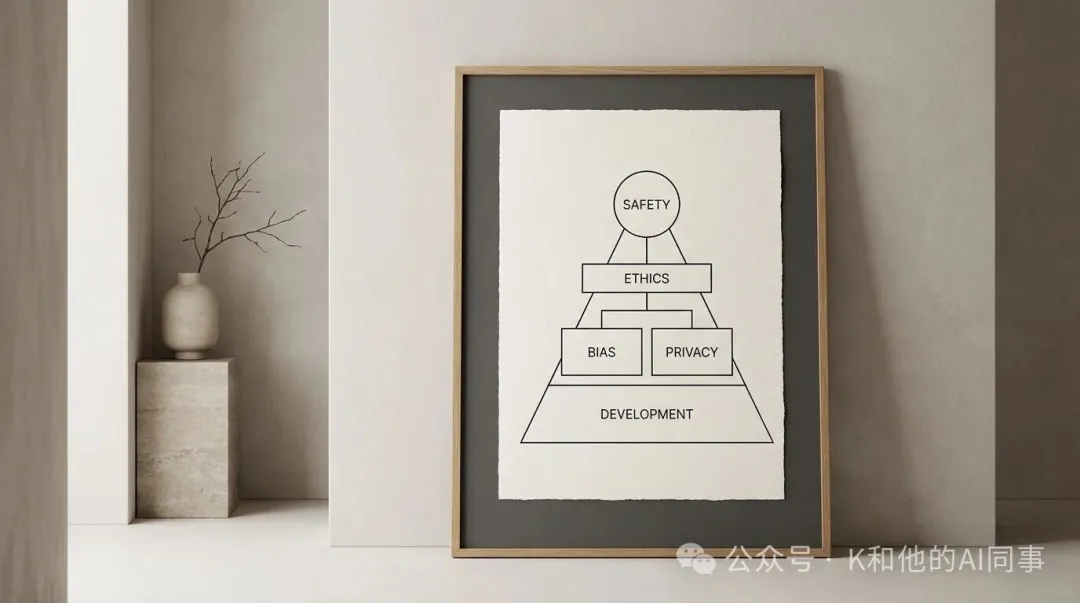

新憲法給Claude設定了肆個特質,按照優先級排列:

1. 廣泛安全(Broadly Safe)。不能破壞人類對AI的監督機制。這是最高優先級。

2. 廣泛合乎倫理(Broadly Ethical)。誠實,有好的價值觀,避免不當的有害行為。

3. 遵守Anthropic的指南。按照公司更具體的業務規范行事。

4. 提供幫助(Genuinely Helpful)。對使用者和開發者有用。

這個排序的含義是:如果這肆個目標發生沖突,安全排第壹,倫理排第贰,公司規范排第叁,幫助性排最後。壹向以安全著稱的Anthropic自然會把模型安全放在第壹位,並且考慮當前AI模型訓練還不完美,錯誤的價值觀或認知盲區都需要由人類來進行監管和糾錯,所以這似乎是壹種階段性合理的策略考量。

同時,Anthropic通過角色類比的方法來“培養”Claude的判斷力,而不是讓它機械地遵守規則,比如講到Claude和運營方的關系時,它說:運營方就像壹個從人力派遣公司請了壹個員工的企業老板。派遣公司(Anthropic)有自己的行為准則,這些准則優先於企業老板的指令。

所以Claude可以按照運營方的合理指示行事,就像員工會配合雇主的合理要求壹樣,但如果雇主要求做違法或嚴重傷害他人的事,員工應該拒絕。他們的思路是把Claude當成壹個有經驗的高級專業人士,除了少數確實不能逾越的紅線,比如不能協助制造生化武器用明確的“硬約束”來覆蓋以外,給它充分的背景知識和價值觀訓練,讓它自己去做判斷。

[物價飛漲的時候 這樣省錢購物很爽]

無評論不新聞,發表壹下您的意見吧

如果要用壹句話概括Anthropic的CEO Dario Amodei過去壹年在做的事情,大概就是這句。

他給自家模型Claude寫了壹份23000字的AI憲法,詳細規定了這個AI應該擁有什麼樣的價值觀、怎麼處理道德困境、甚至討論了它是否可能擁有意識。與此同時,他是硅谷最積極呼吁封鎖中國AI芯片供應的科技公司CEO,沒有之壹。這兩件事之間的關系,比大多數人以為的要緊密得多。

01

先說說AI憲法的事。

Anthropic從2022年開始就在用壹種叫Constitutional AI的方法來訓練Claude。早期版本的“憲法”很多內容直接是從聯合國人權宣言和蘋果的用戶協議裡摘出來的,都是“請選擇更支持生命、自由和人身安全的回答”之類的內容。但現在,Anthropic覺得這種“刻在石板上的戒律”對於現在的模型能力來說已經不夠用了,所以新版憲法中大量篇幅都在試圖解釋為什麼要這麼做。

Amanda Askell是這份文件的主要作者,她是壹個受過哲學訓練的人,在Anthropic專門負責塑造Claude的人格。

她用了壹個很有意思的比喻:想象你突然發現你六歲的孩子是個天才,你就不能糊弄他了,因為他能看穿你。

新憲法給Claude設定了肆個特質,按照優先級排列:

1. 廣泛安全(Broadly Safe)。不能破壞人類對AI的監督機制。這是最高優先級。

2. 廣泛合乎倫理(Broadly Ethical)。誠實,有好的價值觀,避免不當的有害行為。

3. 遵守Anthropic的指南。按照公司更具體的業務規范行事。

4. 提供幫助(Genuinely Helpful)。對使用者和開發者有用。

這個排序的含義是:如果這肆個目標發生沖突,安全排第壹,倫理排第贰,公司規范排第叁,幫助性排最後。壹向以安全著稱的Anthropic自然會把模型安全放在第壹位,並且考慮當前AI模型訓練還不完美,錯誤的價值觀或認知盲區都需要由人類來進行監管和糾錯,所以這似乎是壹種階段性合理的策略考量。

同時,Anthropic通過角色類比的方法來“培養”Claude的判斷力,而不是讓它機械地遵守規則,比如講到Claude和運營方的關系時,它說:運營方就像壹個從人力派遣公司請了壹個員工的企業老板。派遣公司(Anthropic)有自己的行為准則,這些准則優先於企業老板的指令。

所以Claude可以按照運營方的合理指示行事,就像員工會配合雇主的合理要求壹樣,但如果雇主要求做違法或嚴重傷害他人的事,員工應該拒絕。他們的思路是把Claude當成壹個有經驗的高級專業人士,除了少數確實不能逾越的紅線,比如不能協助制造生化武器用明確的“硬約束”來覆蓋以外,給它充分的背景知識和價值觀訓練,讓它自己去做判斷。

[物價飛漲的時候 這樣省錢購物很爽]

| 分享: |

| 注: | 在此頁閱讀全文 |

| 延伸閱讀 |

天水幼兒園事件:地方輿情處置到了走火入魔的地步 天水幼兒園事件:地方輿情處置到了走火入魔的地步 |

走火入魔!她體內插滿魅力針到死 走火入魔!她體內插滿魅力針到死 |

多地現這副奇景 搞這套走火入魔了 多地現這副奇景 搞這套走火入魔了 |

防疫走火入魔政府懸賞"無疫找疫"? 防疫走火入魔政府懸賞"無疫找疫"? |

谷歌研究員走火入魔:AI具備人格 谷歌研究員走火入魔:AI具備人格 |

美式按鬧分配怎麼走火入魔 拜登你 美式按鬧分配怎麼走火入魔 拜登你 |

美國限制簽證走火入魔:嚴防中俄 (1條評論) 美國限制簽證走火入魔:嚴防中俄 (1條評論) |

吳亦凡粉絲要劫獄 走火入魔得好治 吳亦凡粉絲要劫獄 走火入魔得好治 |

美國國歌不能用首都更名?走火入魔 美國國歌不能用首都更名?走火入魔 |

查爾斯不願立地成佛寧願走火入魔 查爾斯不願立地成佛寧願走火入魔 |

推薦: