又是发布AI宪法又是抵制中国,这位AI大佬走火入魔了

墙内自媒体K和他的AI同事文章:对内培养AI的好价值观,对外阻止坏人获取AI能力。

如果要用一句话概括Anthropic的CEO Dario Amodei过去一年在做的事情,大概就是这句。

他给自家模型Claude写了一份23000字的AI宪法,详细规定了这个AI应该拥有什么样的价值观、怎么处理道德困境、甚至讨论了它是否可能拥有意识。与此同时,他是硅谷最积极呼吁封锁中国AI芯片供应的科技公司CEO,没有之一。这两件事之间的关系,比大多数人以为的要紧密得多。

01

先说说AI宪法的事。

Anthropic从2022年开始就在用一种叫Constitutional AI的方法来训练Claude。早期版本的“宪法”很多内容直接是从联合国人权宣言和苹果的用户协议里摘出来的,都是“请选择更支持生命、自由和人身安全的回答”之类的内容。但现在,Anthropic觉得这种“刻在石板上的戒律”对于现在的模型能力来说已经不够用了,所以新版宪法中大量篇幅都在试图解释为什么要这么做。

Amanda Askell是这份文件的主要作者,她是一个受过哲学训练的人,在Anthropic专门负责塑造Claude的人格。

她用了一个很有意思的比喻:想象你突然发现你六岁的孩子是个天才,你就不能糊弄他了,因为他能看穿你。

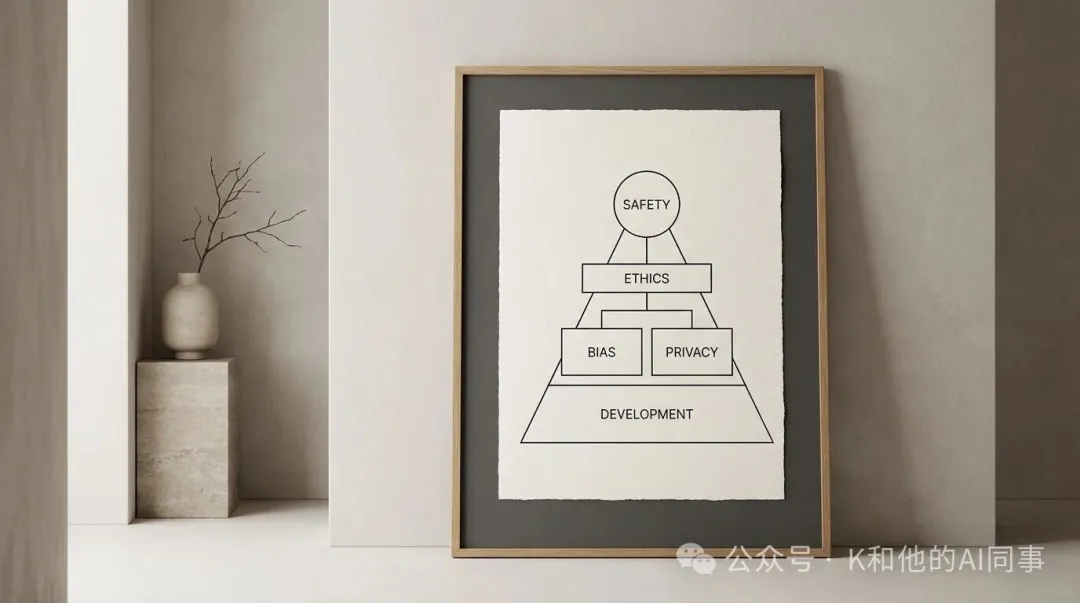

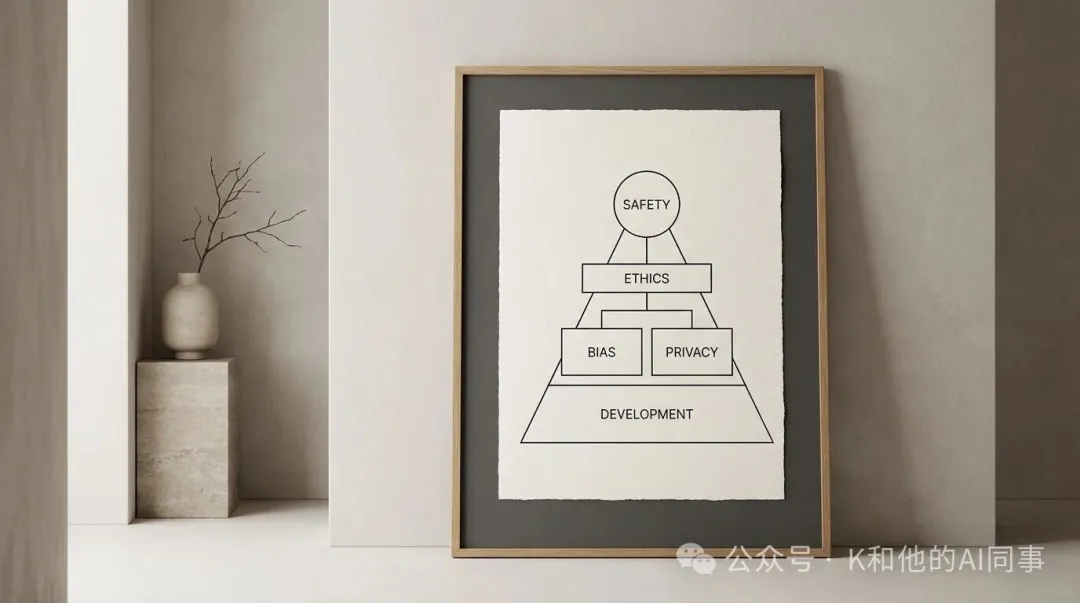

新宪法给Claude设定了四个特质,按照优先级排列:

1. 广泛安全(Broadly Safe)。不能破坏人类对AI的监督机制。这是最高优先级。

2. 广泛合乎伦理(Broadly Ethical)。诚实,有好的价值观,避免不当的有害行为。

3. 遵守Anthropic的指南。按照公司更具体的业务规范行事。

4. 提供帮助(Genuinely Helpful)。对使用者和开发者有用。

这个排序的含义是:如果这四个目标发生冲突,安全排第一,伦理排第二,公司规范排第三,帮助性排最后。一向以安全著称的Anthropic自然会把模型安全放在第一位,并且考虑当前AI模型训练还不完美,错误的价值观或认知盲区都需要由人类来进行监管和纠错,所以这似乎是一种阶段性合理的策略考量。

同时,Anthropic通过角色类比的方法来“培养”Claude的判断力,而不是让它机械地遵守规则,比如讲到Claude和运营方的关系时,它说:运营方就像一个从人力派遣公司请了一个员工的企业老板。派遣公司(Anthropic)有自己的行为准则,这些准则优先于企业老板的指令。

所以Claude可以按照运营方的合理指示行事,就像员工会配合雇主的合理要求一样,但如果雇主要求做违法或严重伤害他人的事,员工应该拒绝。他们的思路是把Claude当成一个有经验的高级专业人士,除了少数确实不能逾越的红线,比如不能协助制造生化武器用明确的“硬约束”来覆盖以外,给它充分的背景知识和价值观训练,让它自己去做判断。

[加西网正招聘多名全职sales 待遇优]

还没人说话啊,我想来说几句

如果要用一句话概括Anthropic的CEO Dario Amodei过去一年在做的事情,大概就是这句。

他给自家模型Claude写了一份23000字的AI宪法,详细规定了这个AI应该拥有什么样的价值观、怎么处理道德困境、甚至讨论了它是否可能拥有意识。与此同时,他是硅谷最积极呼吁封锁中国AI芯片供应的科技公司CEO,没有之一。这两件事之间的关系,比大多数人以为的要紧密得多。

01

先说说AI宪法的事。

Anthropic从2022年开始就在用一种叫Constitutional AI的方法来训练Claude。早期版本的“宪法”很多内容直接是从联合国人权宣言和苹果的用户协议里摘出来的,都是“请选择更支持生命、自由和人身安全的回答”之类的内容。但现在,Anthropic觉得这种“刻在石板上的戒律”对于现在的模型能力来说已经不够用了,所以新版宪法中大量篇幅都在试图解释为什么要这么做。

Amanda Askell是这份文件的主要作者,她是一个受过哲学训练的人,在Anthropic专门负责塑造Claude的人格。

她用了一个很有意思的比喻:想象你突然发现你六岁的孩子是个天才,你就不能糊弄他了,因为他能看穿你。

新宪法给Claude设定了四个特质,按照优先级排列:

1. 广泛安全(Broadly Safe)。不能破坏人类对AI的监督机制。这是最高优先级。

2. 广泛合乎伦理(Broadly Ethical)。诚实,有好的价值观,避免不当的有害行为。

3. 遵守Anthropic的指南。按照公司更具体的业务规范行事。

4. 提供帮助(Genuinely Helpful)。对使用者和开发者有用。

这个排序的含义是:如果这四个目标发生冲突,安全排第一,伦理排第二,公司规范排第三,帮助性排最后。一向以安全著称的Anthropic自然会把模型安全放在第一位,并且考虑当前AI模型训练还不完美,错误的价值观或认知盲区都需要由人类来进行监管和纠错,所以这似乎是一种阶段性合理的策略考量。

同时,Anthropic通过角色类比的方法来“培养”Claude的判断力,而不是让它机械地遵守规则,比如讲到Claude和运营方的关系时,它说:运营方就像一个从人力派遣公司请了一个员工的企业老板。派遣公司(Anthropic)有自己的行为准则,这些准则优先于企业老板的指令。

所以Claude可以按照运营方的合理指示行事,就像员工会配合雇主的合理要求一样,但如果雇主要求做违法或严重伤害他人的事,员工应该拒绝。他们的思路是把Claude当成一个有经验的高级专业人士,除了少数确实不能逾越的红线,比如不能协助制造生化武器用明确的“硬约束”来覆盖以外,给它充分的背景知识和价值观训练,让它自己去做判断。

[加西网正招聘多名全职sales 待遇优]

| 分享: |

| 注: | 在此页阅读全文 |

| 延伸阅读 |

天水幼儿园事件:地方舆情处置到了走火入魔的地步 天水幼儿园事件:地方舆情处置到了走火入魔的地步 |

走火入魔!她体内插满魅力针到死 走火入魔!她体内插满魅力针到死 |

多地现这副奇景 搞这套走火入魔了 多地现这副奇景 搞这套走火入魔了 |

防疫走火入魔政府悬赏"无疫找疫"? 防疫走火入魔政府悬赏"无疫找疫"? |

谷歌研究员走火入魔:AI具备人格 谷歌研究员走火入魔:AI具备人格 |

美式按闹分配怎么走火入魔 拜登你 美式按闹分配怎么走火入魔 拜登你 |

美国限制签证走火入魔:严防中俄 (1条评论) 美国限制签证走火入魔:严防中俄 (1条评论) |

吴亦凡粉丝要劫狱 走火入魔得好治 吴亦凡粉丝要劫狱 走火入魔得好治 |

美国国歌不能用首都更名?走火入魔 美国国歌不能用首都更名?走火入魔 |

查尔斯不愿立地成佛宁愿走火入魔 查尔斯不愿立地成佛宁愿走火入魔 |

推荐: