AI考高数 "卷死"了大帮计算机博士

那么,这是怎么做到的?

AI 狂读 arXiv 上 200 万篇论文

新模型 Minerva,基于 Pathway 架构下的通用语言模型 PaLM 改造而来。

分别在 80 亿、600 亿和 5400 亿参数 PaLM 模型的基础上做进一步训练。

Minerva 做题与 Codex 的思路完全不同。

Codex 的方法是把每道数学题改写成编程题,再靠写代码来解决。

而 Minerva 则是狂读论文,硬生生按理解自然语言的方式去理解数学符号。

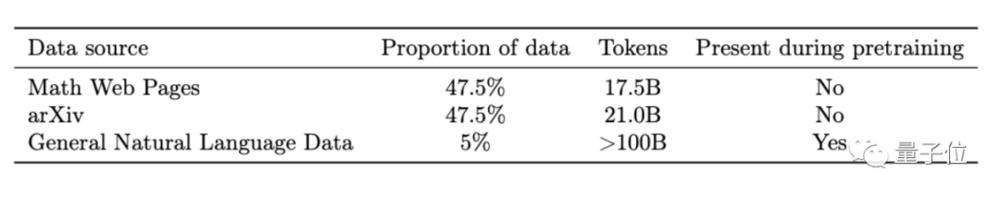

在 PaLM 的基础上继续训练,新增的数据集有三部分:

主要有 arXiv 上收集的 200 万篇学术论文,60GB 带 LaTeX 公式的网页,以及一小部分在 PaLM 训练阶段就用到过的文本。

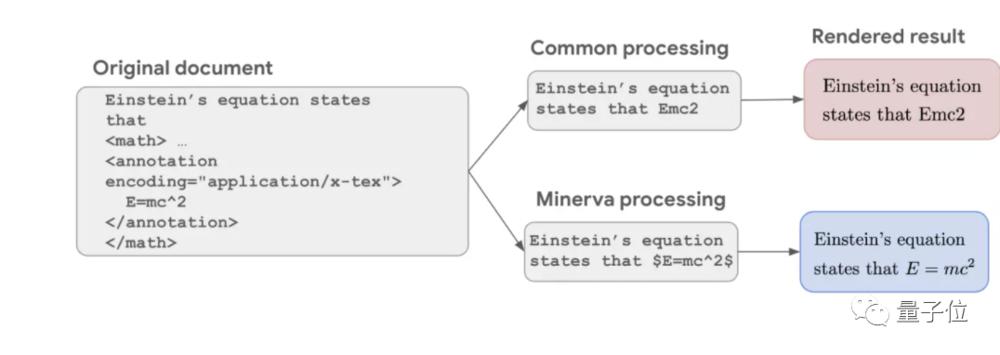

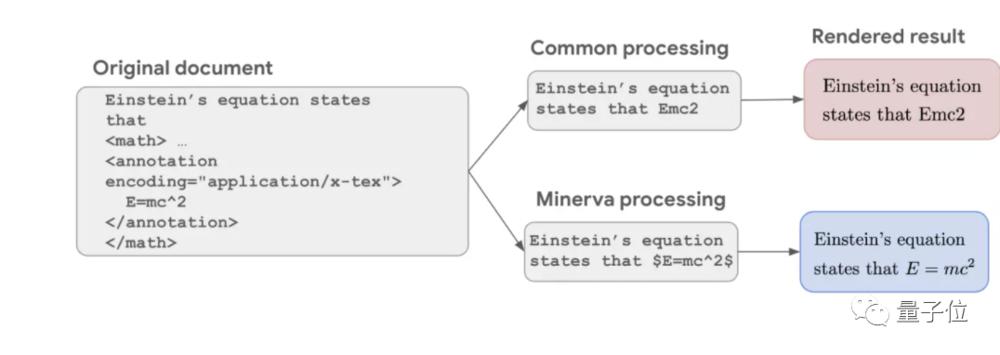

通常的 NLP 数据清洗过程会把符号都删掉只保留纯文字,导致公式不完整,比如爱因斯坦着名的质能方程只剩下了 E=mc2。

但谷歌这次把公式都保留,和纯文本一样走一遍 Transformer 的训练程序,让 AI 像理解语言一样去理解符号。

与之前的语言模型相比,这是 Minerva 在数理问题上表现更好的原因之一。

但与专门做数学题的 AI 相比,Minerva 的训练中没有显式的底层数学结构,这带来一个缺点和一个优点。

缺点,是可能出现 AI 用错误的步骤得到正确答案的情况。

优点,是可以适应不同学科,即使有些问题无法用正规的数学语言表达出来,也可以结合自然语言理解能力解出来。

到了 AI 的推理阶段,Minerva 还结合了多个最近谷歌开发的新技术。

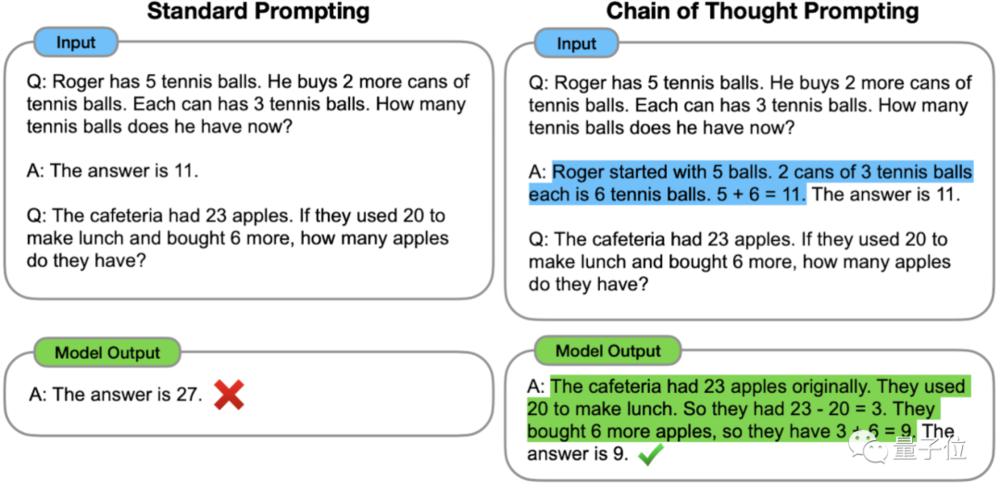

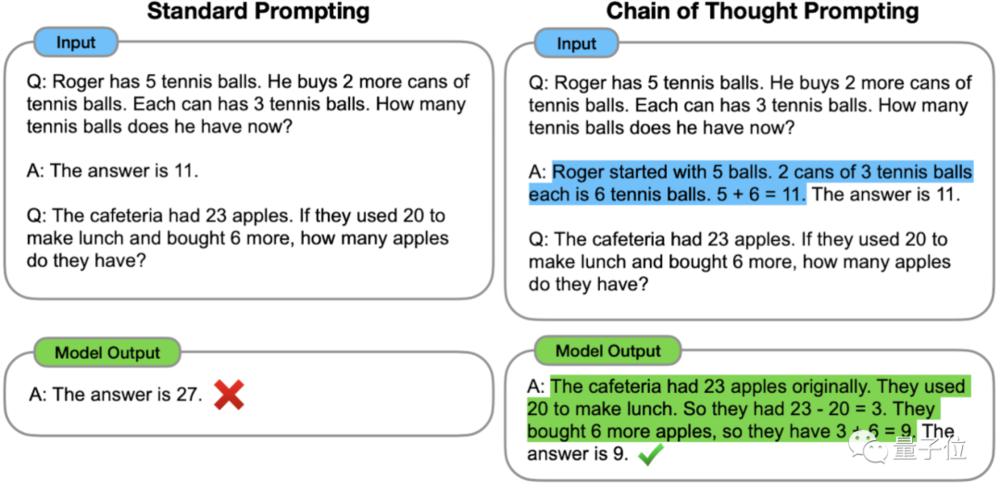

先是 Chain of Thought 思维链路提示,今年一月由谷歌大脑团队提出。

具体来说就是在提问的同时给一个分步骤回答的示例来引导。AI 在做题时就可以采用类似的思考过程,正确回答本来会答错的题目。

[加西网正招聘多名全职sales 待遇优]

无评论不新闻,发表一下您的意见吧

AI 狂读 arXiv 上 200 万篇论文

新模型 Minerva,基于 Pathway 架构下的通用语言模型 PaLM 改造而来。

分别在 80 亿、600 亿和 5400 亿参数 PaLM 模型的基础上做进一步训练。

Minerva 做题与 Codex 的思路完全不同。

Codex 的方法是把每道数学题改写成编程题,再靠写代码来解决。

而 Minerva 则是狂读论文,硬生生按理解自然语言的方式去理解数学符号。

在 PaLM 的基础上继续训练,新增的数据集有三部分:

主要有 arXiv 上收集的 200 万篇学术论文,60GB 带 LaTeX 公式的网页,以及一小部分在 PaLM 训练阶段就用到过的文本。

通常的 NLP 数据清洗过程会把符号都删掉只保留纯文字,导致公式不完整,比如爱因斯坦着名的质能方程只剩下了 E=mc2。

但谷歌这次把公式都保留,和纯文本一样走一遍 Transformer 的训练程序,让 AI 像理解语言一样去理解符号。

与之前的语言模型相比,这是 Minerva 在数理问题上表现更好的原因之一。

但与专门做数学题的 AI 相比,Minerva 的训练中没有显式的底层数学结构,这带来一个缺点和一个优点。

缺点,是可能出现 AI 用错误的步骤得到正确答案的情况。

优点,是可以适应不同学科,即使有些问题无法用正规的数学语言表达出来,也可以结合自然语言理解能力解出来。

到了 AI 的推理阶段,Minerva 还结合了多个最近谷歌开发的新技术。

先是 Chain of Thought 思维链路提示,今年一月由谷歌大脑团队提出。

具体来说就是在提问的同时给一个分步骤回答的示例来引导。AI 在做题时就可以采用类似的思考过程,正确回答本来会答错的题目。

[加西网正招聘多名全职sales 待遇优]

| 分享: |

| 注: | 在此页阅读全文 |

推荐:

AI考高数 "卷死"了大帮计算机博士

AI考高数 "卷死"了大帮计算机博士