[留學生] 中留學生論文登Nature 大模型對人類可靠性降低

作者介紹

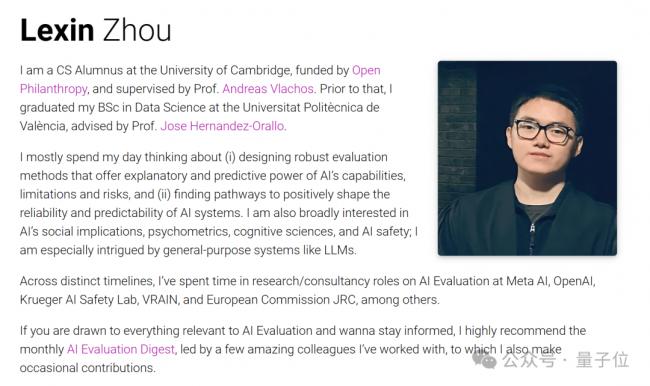

論文壹作 Lexin Zhou(周樂鑫),目前剛從劍橋大學CS碩士畢業(24歲),研究興趣為大語言模型評測。

在此之前,他在瓦倫西亞理工大學獲得了數據科學學士學位,指導老師是Jose Hernandez-Orallo教授。

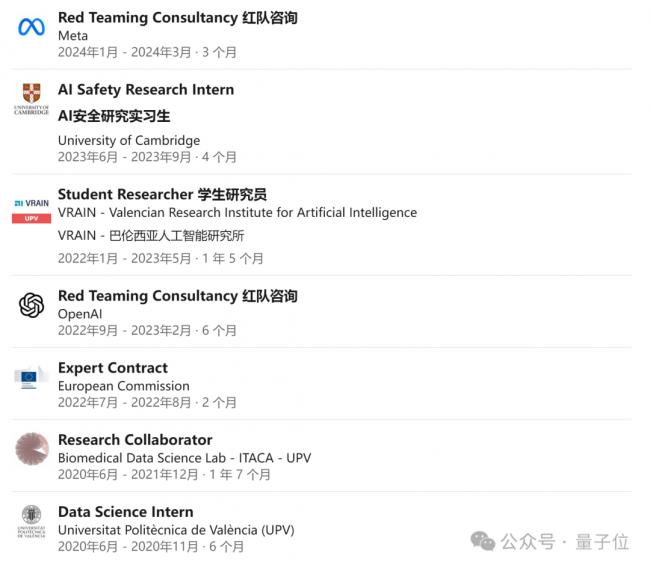

個人主頁顯示,他曾有多段工作實習經歷。在OpenAI和Meta都參與了紅隊測試。 (Red Teaming Consultancy )

關於這篇論文,他重點談到:

通用人工智能的設計和開發需要進行 根本性轉變,特別是在高風險領域,因為可預測的錯誤分布至關重要。在此實現之前, 依賴人類監督是壹種危險。

評估模型時,考慮人類認為的難度和評估模型的回避行為,可以更全面地描述模型的能力和風險,而不僅僅關注在困難任務上的表現。

通用人工智能的設計和開發需要進行 根本性轉變,特別是在高風險領域,因為可預測的錯誤分布至關重要。在此實現之前, 依賴人類監督是壹種危險。

評估模型時,考慮人類認為的難度和評估模型的回避行為,可以更全面地描述模型的能力和風險,而不僅僅關注在困難任務上的表現。

論文也具體提到了導致這些不可靠性的壹些可能原因,以及解決方案:

在Scaling-up中,近幾年的benchmarks越來越偏向於加入更多困難的例子,或者給予所謂“權威”來源更多權重,研究員也因此更傾向於優化模型在困難任務上的表現,導致在難度壹致性上慢性惡化。

在shaping-up中(如RLHF),被雇傭的人傾向於懲罰那些規避任務的答案,導致模型更容易在面對自己無法解決的難題時“胡說八道”。

[物價飛漲的時候 這樣省錢購物很爽]

無評論不新聞,發表壹下您的意見吧

論文壹作 Lexin Zhou(周樂鑫),目前剛從劍橋大學CS碩士畢業(24歲),研究興趣為大語言模型評測。

在此之前,他在瓦倫西亞理工大學獲得了數據科學學士學位,指導老師是Jose Hernandez-Orallo教授。

個人主頁顯示,他曾有多段工作實習經歷。在OpenAI和Meta都參與了紅隊測試。 (Red Teaming Consultancy )

關於這篇論文,他重點談到:

通用人工智能的設計和開發需要進行 根本性轉變,特別是在高風險領域,因為可預測的錯誤分布至關重要。在此實現之前, 依賴人類監督是壹種危險。

評估模型時,考慮人類認為的難度和評估模型的回避行為,可以更全面地描述模型的能力和風險,而不僅僅關注在困難任務上的表現。

通用人工智能的設計和開發需要進行 根本性轉變,特別是在高風險領域,因為可預測的錯誤分布至關重要。在此實現之前, 依賴人類監督是壹種危險。

評估模型時,考慮人類認為的難度和評估模型的回避行為,可以更全面地描述模型的能力和風險,而不僅僅關注在困難任務上的表現。

論文也具體提到了導致這些不可靠性的壹些可能原因,以及解決方案:

在Scaling-up中,近幾年的benchmarks越來越偏向於加入更多困難的例子,或者給予所謂“權威”來源更多權重,研究員也因此更傾向於優化模型在困難任務上的表現,導致在難度壹致性上慢性惡化。

在shaping-up中(如RLHF),被雇傭的人傾向於懲罰那些規避任務的答案,導致模型更容易在面對自己無法解決的難題時“胡說八道”。

[物價飛漲的時候 這樣省錢購物很爽]

| 分享: |

| 注: | 在此頁閱讀全文 |

| 延伸閱讀 | 更多... |

推薦: